[digital creator](デジタルクリエーター) って肩書き、

ちょっと憧れたこともあります。

ということで、web系の仕事にもサロンの方でも、今後何かに活用できそうなので、

ネット上の諸先輩方の情報をありがたく参考にさせていただきつつ

いくつかあるやり方の中で、まずは一番簡単な方法をチョイスしてみました。

環境構築の流れなどはまだまだなので流れのみサラッと。

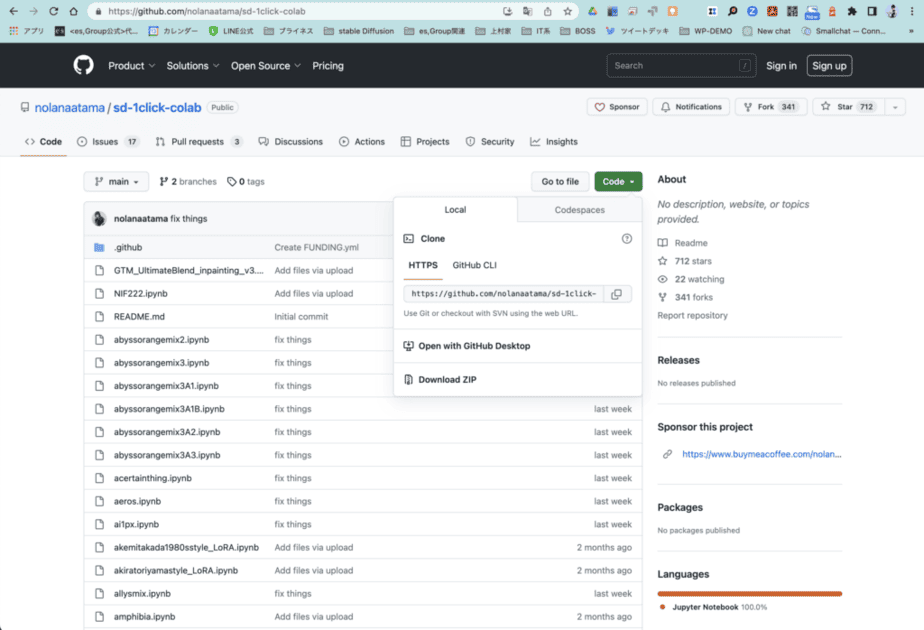

まずは、[GitHub]から[ChilloutMix]をDL

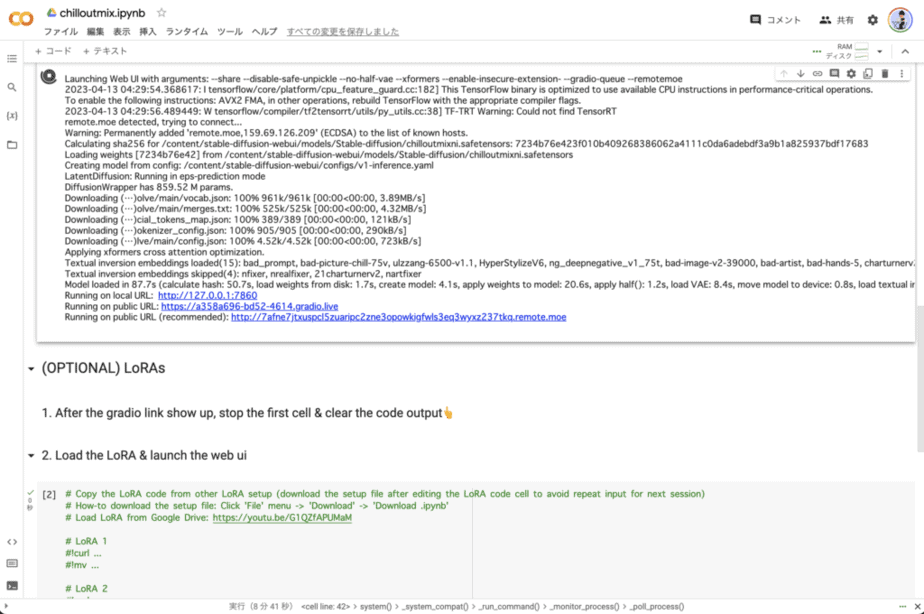

次に[Google Colaboratory]にアクセスしてDLデータ内の[chilloutmix.ipynb]をアップロード

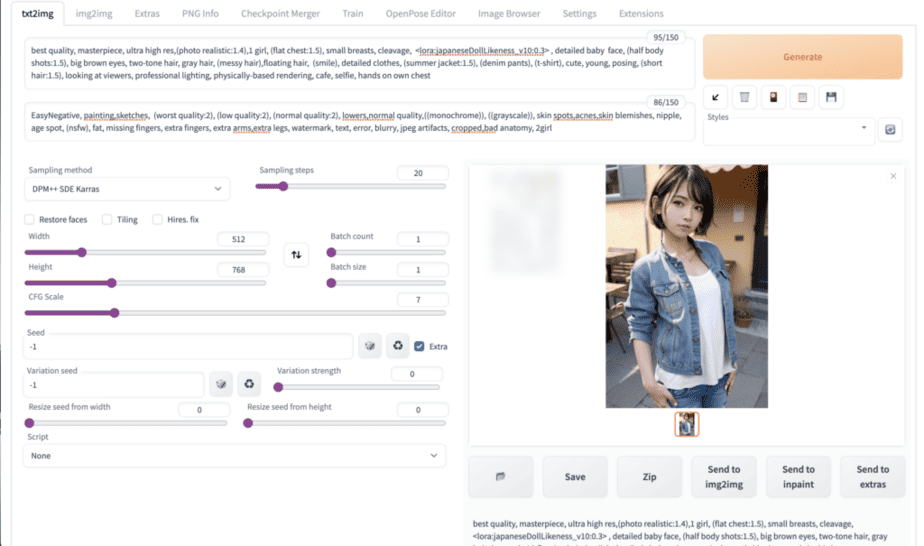

諸々「実行、停止、消去、実行、URL発行、アクセス」して

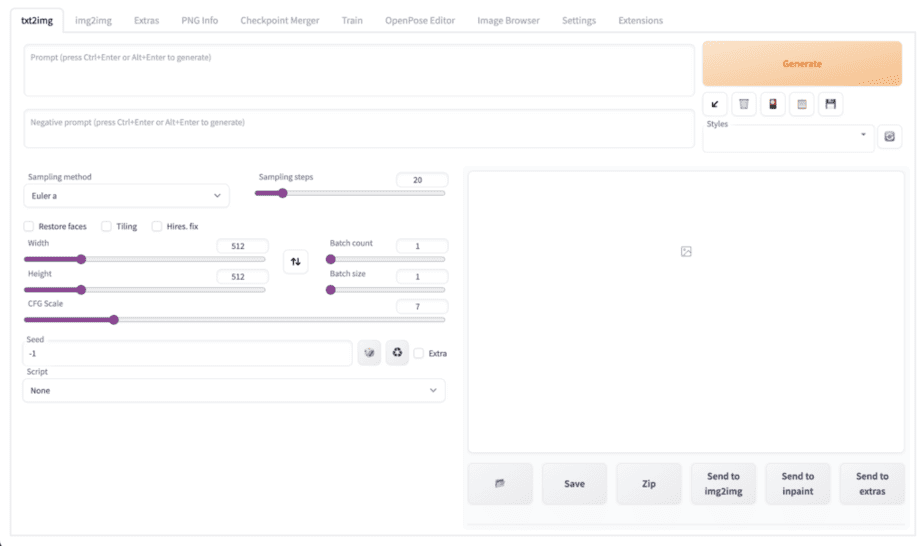

[Stable Diffusion webui]の準備完了です。まずはなにもない状態からスタート。

LoRAは[japanesedolllikeness_LoRA.ipynb]を選択して

リアルヘアモデルの撮影の時と同じように

- 長さや髪色、スタイル

- 表情やポージングや衣装

- 背景やカメラアングルに光の方向

などを中心にChatGPTさんに[positive prompt]と[negative prompt]を作ってもらい

いざ[Generate]

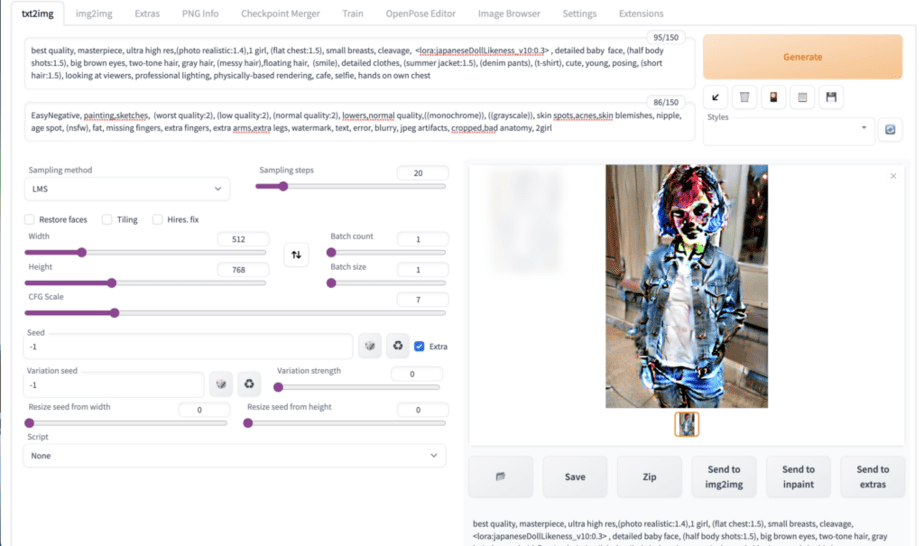

おかしなことになって吹き出しそうになり、

[Sampling method]がおかしかったので[DPM++SDE Karras]に変更して再Generate

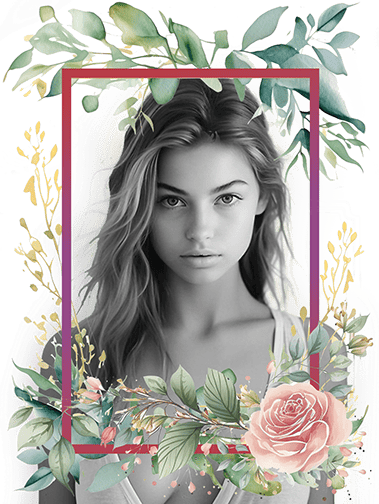

日本人でショートボブで、目はブラウンで、

サマージャケットにTシャツ、デニムで、

カフェでいい感じのボブが風に吹かれた感じのモデル写真ができました。

こんな感じでpromptや設定を色々試行錯誤しながら

ヘアスタイルをある程度イメージ通りに表現できないかな〜と言った感じです。

色々試した感想としては、

「たぶん作れない写真はないな」(ヘアに関わらずどんな業界の表現も可能)ということと、

「繊細な髪の表現は実際に切った方が思った通りの表現になるな」という

ごくごく当たり前のこととなりましたが、

ちょっと「これいいんでない?」というやり方も見えてきまして、

まずは「ヘア」に特化した形で色々テストしてみます。

https://www.instagram.com/webui_okinawa/

Tiktok